本文目录一览:

- 1、英伟达新一代GPU大起底:A100、H100、L40S和H200横向对比

- 2、震撼发布:英伟达H200,AI芯片领域的新巨头

- 3、一文读懂英伟达的“新GPU”:比H100快5倍?1200W的功耗?液冷?与MI300X比...

- 4、英伟达卡的核数

- 5、「每日必看的AI前沿」英伟达发布新一代AI芯片H200

英伟达新一代GPU大起底:A100、H100、L40S和H200横向对比

1、英伟达新一代GPU大起底:A100、H100、L40S和H200横向对比 英伟达作为GPU领域的领头羊,不断推出创新产品以满足日益增长的计算需求。从A100到H200,每一代产品都带来了显著的性能提升和新的技术特性。

2、NVIDIA A100、H100、L40S和H200在架构、性能参数和应用场景上各有特色。A100作为首款Ampere架构GPU,为后续的GPU产品奠定了坚实的基础;H100在AI训练和推理速度、内存容量和带宽等方面有显著提升;L40S则更注重推理性能和实时光线追踪能力;而即将发布的H200则将在AI和高性能计算领域提供前所未有的性能。

3、英伟达GPU系列未来展望随着英伟达不断推陈出新,GPU技术正向更高性能、更大规模和更广泛的应用领域迈进。从B100到H200,再到L40S,每一款新品都代表着技术的前沿与创新。未来,英伟达GPU将在AI、大数据处理、科学计算等领域的应用中发挥更关键的作用,推动科技进步与产业创新。

震撼发布:英伟达H200,AI芯片领域的新巨头

1、在2023年的全球超算大会(SC2023)上,英伟达震撼发布了世界上最强大的AI芯片——H200。这款全新的GPU不仅在前一代霸主H100的基础上实现了惊人的性能提升,更以其卓越的技术突破和革命性的AI性能,成为了AI芯片领域的新巨头。

2、英伟达于11月13日正式发布了新一代AI芯片H200,这款芯片作为当前用于训练大模型的H100芯片的升级产品,在性能和内存方面实现了显著提升。其中,H200首次采用了HBM3e内存,这一创新成为其升级的重点。H200与HBM3e的革新 H200芯片通过引入HBM3e内存,实现了内存速度和容量的双重飞跃。

3、据新浪网报道,英伟达于近日发布了新一代AI芯片H200 Tensor Core GPU。这款芯片作为英伟达在AI领域的又一力作,具有显著的技术突破和性能提升。技术亮点 首款配备HBM3e的GPU:H200是英伟达首款采用HBM3e(高带宽内存第三代增强版)的GPU,这一创新使得H200的内存容量更大、速度更快。

4、英伟达近期正式发布了其最新的AI算力芯片H200,这款芯片在性能上相较于前代旗舰H100有了显著提升。然而,尽管H200性能强大,但由于多种因素,用户可能难以购买到这款产品。H200性能提升显著 据英伟达官方透露,H200相比H100,在性能上直接提升了60%到90%。

5、以FP8为例,8卡组合可提供约32Petaflops的计算能力,这一数据进一步验证了H200在实际应用中的强大算力。总结:英伟达H200芯片凭借其强大的算力,被誉为AI算力巨兽。在AI训练和推理领域,H200具有显著优势,能够处理大规模、高复杂度的AI任务,为人工智能的发展提供强有力的支持。

6、英伟达H200芯片是一款NVIDIA新一代人工智能(AI)芯片,旨在培训和部署各种人工智能模型。以下是关于英伟达H200芯片参数的详细介绍:内存:H200集成了141GB的HBM3e内存,这一容量几乎是NVIDIA H100 Tensor核心GPU的两倍。这使得H200在处理大规模数据集和复杂模型时具有更高的效率和性能。

一文读懂英伟达的“新GPU”:比H100快5倍?1200W的功耗?液冷?与MI300X比...

英伟达在AI盛会GTC上发布了新一代Blackwell架构GPU,作为Hopper架构的后继者,Blackwell在性能提升方面表现出色,最高规格的Blackwell芯片浮点运算速度(FLOPS)大约快了5倍,能耗也进一步优化。以下是对Blackwell架构GPU的详细解读,以及与H100、MI300X的比较。

与英伟达产品的对比:在与英伟达H100和H200等高端芯片的对比中,MI300X在显存容量方面占据优势。尽管H100和H200在算力方面表现出色,但MI300X的显存容量使其在处理大模型时更具竞争力。同时,需要注意的是,NVIDIA CUDA在软硬件协同使用方面的增益显著,整体优势依旧明显。

在尖端芯片领域,AMD的MI300X成为焦点。这款芯片采用AMD最新的CDNA3 GPU架构,搭配192GB HBM3显存,性能相比前代提升约八倍,是AMD的最强芯。MI300X是ARM Instinct MI300加速器,而MI300A则是一款APU。MI300X和MI300A构成了MI300系列,后者主要用于计算集群或服务器。

AMD集成DeepSeek-V3到MI300X GPU,能在一定程度上与英伟达抗衡,但短期内难以撼动英伟达的主导地位。AMD宣布将DeepSeek-V3模型集成到其Instinct MI300X GPU上,这一举措显示了AMD在AI推理领域的积极布局。

以英伟达H100为例,其FP32算力高达600TFLOPS(万亿次浮点运算),而国内芯片如华为海思的Atlas 300T A2虽然也达到了较高的算力水平,但相比之下仍有差距。在能效比方面,国外芯片也普遍优于国内芯片,这意味着在相同功耗下,国外芯片能够提供更高的计算性能。

实际应用:在选择GPU时,除了考虑显存、显存带宽和算力等指标外,还需要关注其外部通信接口的性能。例如,AMD的MI300X采用了PCIE0接口,虽然低于英伟达的H100,但在实际应用中,由于深度学习任务通常对硬盘和GPU之间的通信速度要求不是特别高(即数据加载不是瓶颈),因此这一差异对整体性能的影响有限。

英伟达卡的核数

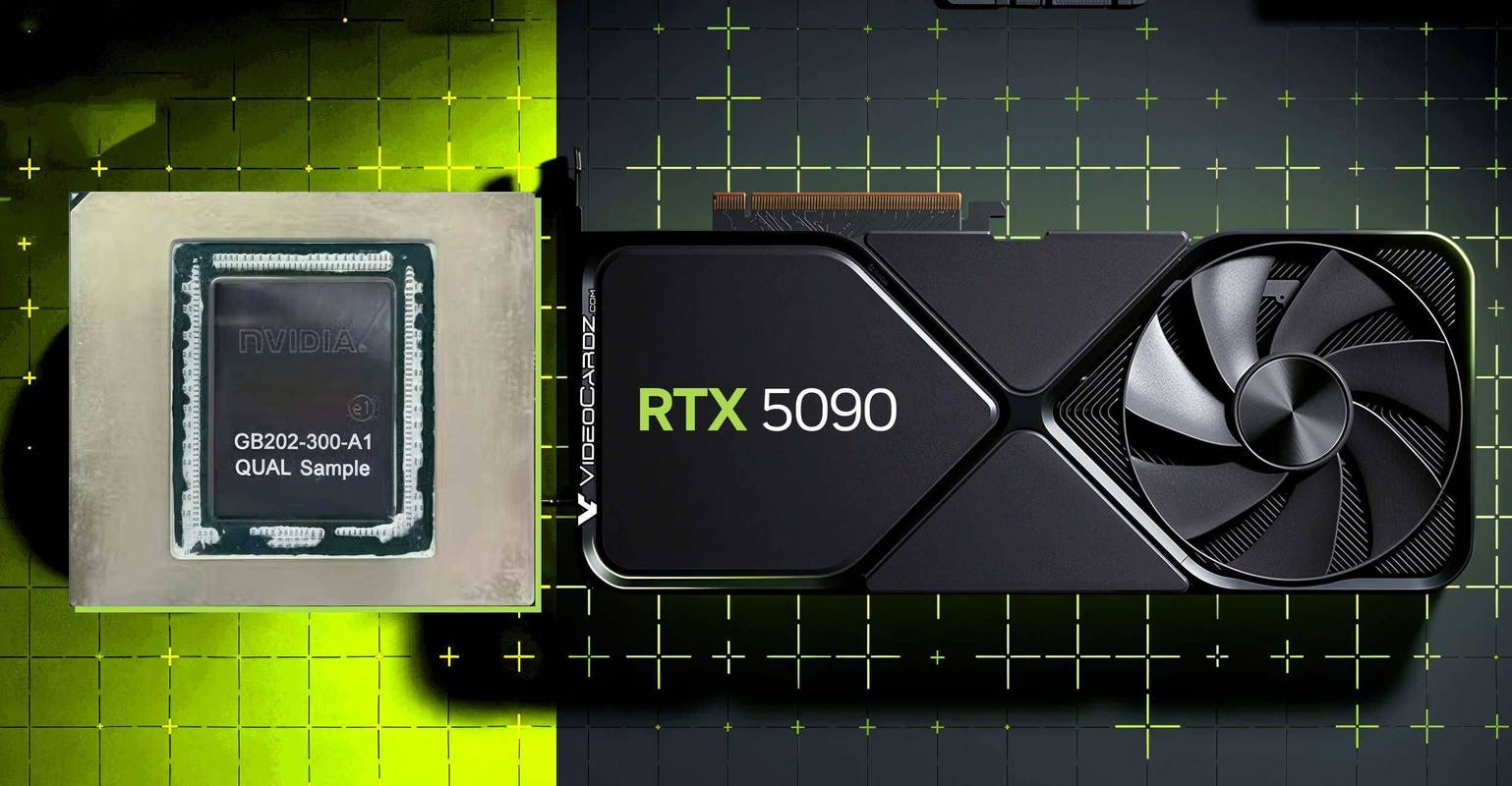

英伟达显卡的核心数量因型号和定位差异显著,2025年最新发布的RTX 50系列旗舰型号RTX 5090 CUDA核心数达21760个,而主流型号及AI计算卡的核心配置进一步覆盖从数千到数万的范围。

GPU核心数量:A100 GPU卡可以提供7个独立的GPU核心,这意味着用户可以根据实际需求,灵活地将一块GPU卡划分为多个虚拟GPU,实现多种不同的容量分配方式。显存分配方式:除了传统的显存分配方式外,A100还引入了5G、10G等更为灵活的显存分配方式,进一步提升了资源利用的灵活性和效率。

英伟达 RTX 4050 早期爆料信息汇总:CUDA 核心数量:3072 个显存:8GB(128bit)功耗:150W详细分析:CUDA 核心数量:RTX 4050 预计将搭载 3072 个 CUDA 核心,这一数字相较于上一代产品有了显著提升,预示着其在并行计算能力上将有较大进步。

「每日必看的AI前沿」英伟达发布新一代AI芯片H200

据新浪网报道,英伟达于近日发布了新一代AI芯片H200 Tensor Core GPU。这款芯片作为英伟达在AI领域的又一力作,具有显著的技术突破和性能提升。技术亮点 首款配备HBM3e的GPU:H200是英伟达首款采用HBM3e(高带宽内存第三代增强版)的GPU,这一创新使得H200的内存容量更大、速度更快。

英伟达于11月13日正式发布了新一代AI芯片H200,这款芯片作为当前用于训练大模型的H100芯片的升级产品,在性能和内存方面实现了显著提升。其中,H200首次采用了HBM3e内存,这一创新成为其升级的重点。H200与HBM3e的革新 H200芯片通过引入HBM3e内存,实现了内存速度和容量的双重飞跃。

在2023年的全球超算大会(SC2023)上,英伟达震撼发布了世界上最强大的AI芯片——H200。这款全新的GPU不仅在前一代霸主H100的基础上实现了惊人的性能提升,更以其卓越的技术突破和革命性的AI性能,成为了AI芯片领域的新巨头。

英伟达近期正式发布了其最新的AI算力芯片H200,这款芯片在性能上相较于前代旗舰H100有了显著提升。然而,尽管H200性能强大,但由于多种因素,用户可能难以购买到这款产品。H200性能提升显著 据英伟达官方透露,H200相比H100,在性能上直接提升了60%到90%。

本文来自作者[covision]投稿,不代表共绘号立场,如若转载,请注明出处:https://co-vision.cn/xinw/202510-12417.html

评论列表(3条)

我是共绘号的签约作者“covision”

本文概览:本文目录一览: 1、英伟达新一代GPU大起底:A100、H100、L40S和H200横向对比...

文章不错《英伟达新GPU发布(英伟达2021新品)》内容很有帮助